생성AI(Generative AI)는 주어진 명령에 따라 이미지, 텍스트, 비디오를 만들어낸다.

AI챗봇은 엄청난 분량의 학습 능력으로 사람과 같은 수준의 답을 도출한다. 그래서 비디오나 영화 제작에 AI를 도입하려는 시도도 많다.

사전이나 사후 편집, 그래픽 작업에는 이미 AI가 대세로 자리잡고 있다.

최근에는 콘텐츠 촬영 제작에도 AI를 활용하고 있다. 특정 이미지나 텍스트, 비디오를 이용해 사람의 손을 쓰지 않고 또 다른 비디오를 생성하는 것이다. 아바타도 마찬가지다.

그러나 결론부터 말하지만, 적어도 현재까지는 생성AI는 전통적인 비디오 제작 시스템에는 큰 영향을 미치지 못할 것으로 보인다. 전체 과정에서 인간이 개입이 필요한 단계가 요소가 워낙 많기 때문이다. 하지만, AI기술은 빠르게 발전하고 있다.

[텍스트 비디오 변환 AI솔루션]

텍스트 명령을 비디오로 생성해주는 AI모델은 글을 입력하면 지시대로 합성 비디오(synthesize video)를 만든다. 텍스트 비디오 변환 AI툴은 Gen-2 (Runway), Make-A-Video(메타), Imagen Video (구글), Phenaki (구글) 등이 경쟁하고 있다. 그러나 런웨이 제품을 제외하고는 상용 제품은 아직 나오지 않았다.

메타는 연내 발표를 앞두고 있다. 오픈AI역시, 챗GPT에 비디오 생성 능력을 추가하겠다고 밝힌 바 있다.

런웨이(Runway)는 2023년 3월 ‘텍스트 비디오 변환’ AI모델 ‘Gen-2’를 공개했다. 자체 기술로 텍스트를 비디오로 만들어주는 첫 번째 공개 AI모델이다.

런웨이 AI변환툴은 할리우드에서도 적용되고 있다. 미쉘 예가 여우 주연상을 받은 오스카 수상 영화 ‘ Everything, Everywhere, All at Once’에는 런웨이의 AI편집툴이 쓰였다.

이 영화의 비주얼 이펙트 아티스트 에반 홀렉(Evan Halleck)은 ‘락 유니버스 신’에서 런웨이의 편집툴을 썼다. 런웨이 AI툴(그린 스크린)을 써서 대형 블루스크린을 이용하지 않고 이미지로부터 배경을 없앤 것이다. 제작도 빨랐고 제작비도 거의 들지 않았다.

런웨이가 할리우드 제작에 AI 적용에 눈을 돌린 이유는 창업주가 전형적인 테크 기업 출신이 아니기 때문이다.

창업주 중 한명인 발렌시아(Valenzuela)는 칠레 산티아고에 있는 아돌포 이바네즈 대학(Universidad Adolfo Ibánez)에서 디자인 석사 과정을 이수하고 학부 과정에서는 경제학과 경영학을 공부했다.

런웨이는 풀 스택 전략(full-stack strategy, 개발부터 생산까지 가능한)도 만들었다.

이는 실리콘밸리 투자자들을 매혹시켰다. 스타트업 런웨이는 2023년 시리즈D투자에서 1억 달러(1,300억 원)를 모았다.

AI에 관심이 많은 VC(Amplify Partners, Lux Capital, Madrona, Coatue, Felicis Ventures)가 회사 투자에 참여했다.

하지만, AI 텍스트 영상 변환 솔루션은 갈길이 멀다.

AI가 영상은 만들지만 여전히 고품질 영화, 프리미엄 TV가 원하는 품질은 생성AI의 능력을 넘어선다.

현 상황에서 AI애플리케이션이 만들어 내는 품질은 단편 애니메이션과 저화질, 저품질 비디오(수초에서 길어야 수 분)다. ‘젠2(Gen)2’ 역시 텍스트를 비디오로 만들어내는 능력 있지만 결과물은 짧고 해상도가 낮다.

[넷플릭스 일본, 텍스트 이미지 변환 AI 이용 제작]

아직까지는 처음부터 생성AI를 사용해 만든 상업 영화는 없다. 그러나 텍스트 이미지 변환 모델( text-to-image model)을 이용, 단편 영화나 실험적 프로젝터를 만드는 테스트는 이어지고 있다.

넷플릭스 재팬은 단편 애니메이션 ‘개와 소년(The Dog and the Boy)’ 배경 이미지를 생성 AI를 이용해 만들었다. 이 백그라운드는 AI가 색감과 질감을 만들기 전에 손그림으로 그려졌다.

AI 실험 단편 ‘소금(Salt)’은 ‘텍스트 이미지 변환 AI ‘미드저니(Midjourney)’를 사용해 이미지를 생성했다. 미드저니를 사용해, 이미지를 애니메이션으로 보이도록 조작도 했다.

[이미지, 비디오 이용, 비디오 생성하는 AI솔루션 등장]

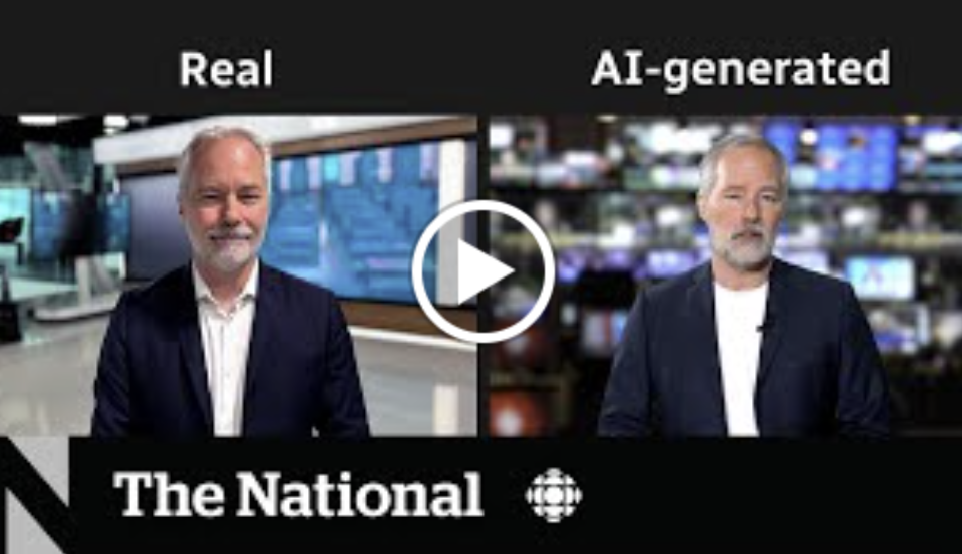

이외 ‘텍스트-비디오가 아닌’ ‘이미지나 비디오를 이용해 다른 비디오를 만들어 내는’ 생성AI 비디오 애플리케이션도 있다. 가장 일반적인 툴은 움직임이나 사람을 복제한(혹은 닮은) 아바타를 만들어 이를 비디오 제작에 활용하는 것이다.

우리가 흔히 말하는 디지털 휴먼이나 복제인간, 디지털 트윈 등이다. 주로 비즈니스 프레젠테이션, 공공기관의 발표, 뉴스 등에 사용된다. 그러나 아직은 AI 비디오 제작은 퀄리티가 매우 스펙트럼하다. 물론 AI 비디오 아바타들은 실사 영화나 전통 애니메이션 영화에 비해 움직임이나 적용 가능성이 제한적이다.

AI 생성 아바타는 현재까지는 고객 지원 센터, 마케팅, 영업, 기술 훈련, 소셜 공유를 위한 흥미 등의 비즈니스에 용도가 그치고 있다.

하지만, 개발 속도는 빠르다. 인간에 더 가깝게, 특정인이 없어도 특정인이 발표하는 영상을 만들 수 있도록 발전하고 있다.

AI 립싱크 모바일 앱(lip-syncing mobile app) ‘Wombo’를 이용하면 개인 셀프 카메라 이미지를 이용해 움직이는 아바타를 만들 수 있다. 만들어진 이미지는 노래도 부르고 미소짓고 눈도 깜박인다.

여기에 목소리를 입히면 노래는 부르는 영상도 손쉽게 만들 수 있다. 또 일론 머스크가 마치 자신의 목소리로 말하는 것처럼도 꾸밀 수 있다.

AI 아바타 회사 신세시아(Synthesia)는 말하는 사람의 3~4분 분량 영상으로 개인 아바타를 만들어낼 수 있는 툴을 내놨다.

[향후 전망-AI가 제작자를 대체할 것인가?]

AI비디오 제작 기술은 결국 터테인먼트 스튜디오서 쓸 수 있을 정도로 발전할 것으로 보인다. 하지만, 아직은 최소 몇 년의 시간이 필요해 보인다. 하지만, 시간이 문제다. 지금 AI 아바타는 줌회의나 비즈니스 프레젠테이션에서 쓸 수 있을 정도다. 다른 창작 영역에서는 적용이 쉽지 않다. 결국 신뢰성의 문제다.

사실 텍스트 이미지 변환 솔루션보다는 ‘이미지(비디오) 비디오 변환 솔루션’의 발전 속도가 더 빠를 수 밖에 없다.

이미지를 이용해 비디오를 만드는 AI모델들은 현재 아바타를 넘어 분위기가 까지 만들어낼 수 있다.

알파벳 소유 AI 툴 개발 회사 ‘딥마인드AI(DeepMind AI)’는 이미지-비디오 변환 모델 ‘트랜스플래머(Transframer)’를 개발 중이다. 이 툴은 사진 프레임을 너머의 주변 배경 컨텍스트로 유추해 30초 분량의 비디오를 생성한다.

한 줄의 글을 ‘원 클릭’으로 장편 영화로 둔갑시키는 상상은 아직은 이르다. 최소 몇 년은 걸릴 장기 프로젝트다. 생성AI모델의 발전과 신제품 출시 속도를 볼 때 우리가 생각했던 것보다 ‘현실적인 비디오’를 만드는 작업은 더 빠를 수 있다.

이럴 경우 콘텐츠 제작 생태계는 큰 변화를 겪을 수 밖에 없다.

AI가 저장된 라이브러리 비디오 영상에서 또 다른 영화나 다큐멘터리를 만들어낼 수 있다면 혹은 이에 준하는 텍스트 비디오 변환 AI(Text-to-video AI)가 만들어진다면 그야 말로 모든 것이 바뀌는 레짐 체인지가 벌어질 수 있다. 영화, TV제작 관행과 일하는 사람들의 직업도 변할 수 밖에 없다.

참고 AI 제작 관련 솔루션

텍스트- 비디오 변환 AI(Text-to-video)

- Gen-2 (Runway), Make-A-Video(메타), Imagen Video (구글), Phenaki (구글)

이미지- 비디오 변환(Image- to-video)

-웜보(Wombo)

비디오- 비디오 변환(Video-to video, 아바타)

-Soul Machines, AI Foundation, Synthesia

![[Report]Ofcom 'Future of TV Distribution'](https://storage.googleapis.com/cdn.media.bluedot.so/bluedot.directmedialab/2024/05/guwd3g_202405122027.png)

![[PT]NAB2024 the Era of conversational AI](https://storage.googleapis.com/cdn.media.bluedot.so/bluedot.directmedialab/2024/05/qc7q4b_202405081558.png)

![[PPT-Report]대화형 AI의 시작 "NAB2024"](https://storage.googleapis.com/cdn.media.bluedot.so/bluedot.directmedialab/2024/05/yhln3l_202405081556.png)