Open AI has released a generative AI text-to-video (T2V) tool. It's called sora, and it's a generative AI that lets you type in text and generate an image of your choice.

OpenAI introduced the features, differences, and future development of sora, an AI video generator, in detail on the company's blog. Generative AI, which creates videos, images, and text based on given commands (prompts), is taking the creative world by storm.

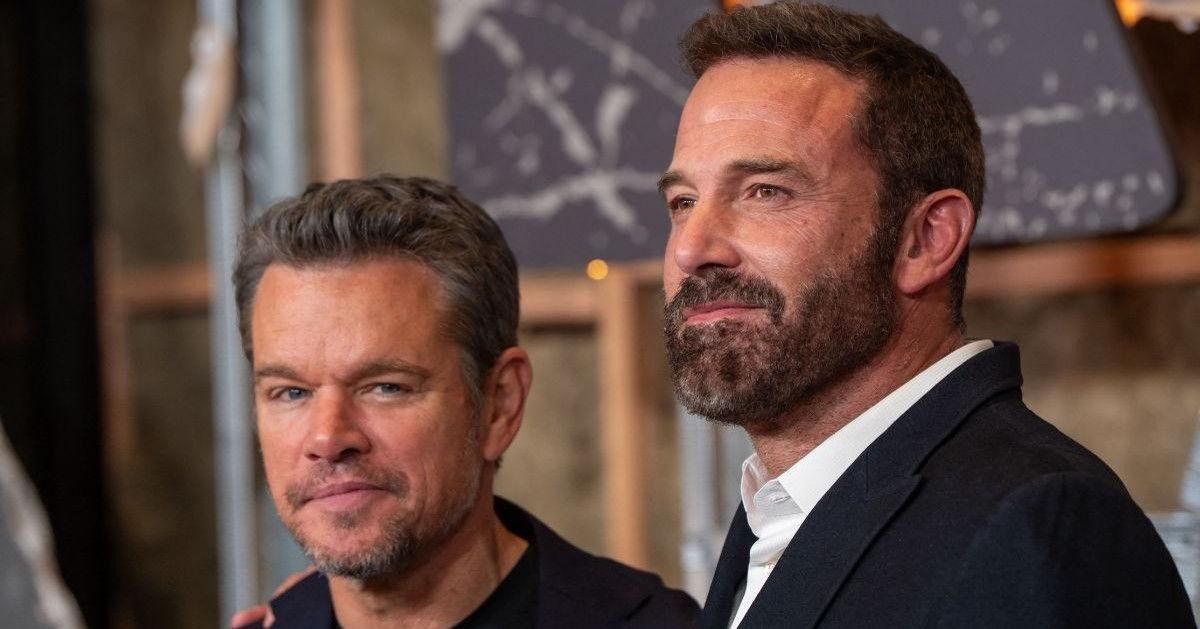

The use of AI was a major issue in the 2023 Hollywood writers' (WGA) and actors' (SAG-AFTRA) strike. Many writers and actors are already using AI in their creative endeavors.

AI is moving beyond assisting on set to taking ownership, and with advances like Sora, video-generating AI can take charge from the beginning (script) to the end (video). In this sense, AI in 2024 is likely to change the landscape of the creator economy.

Sora is similar to AI video creation tools like Meta and Google, as well as AI video startups Runway and Pika Labs, but it takes the technology to the next level of AI representation.

Traditional generative AI-based video generators have struggled to accurately simulate complex scenes, especially when it comes to understanding cause and effect;

For example, if you order a video of a person taking a bite out of a cookie, Generative AI will create both the cookie and the person. But in reality, the cookie might not have a "bite mark" on it.

They also often confuse the spatial details of prompts, such as confusing left with right, and are unable to accurately describe events in chronological order, such as following a specific camera trajectory. Open AI says that Sora AI significantly addresses these weaknesses in video generation solutions.

오픈AI가 생성AI 텍스트 기반 비디오(text-to-video (T2V)) 툴을 내놨다. 소라(sora)라는 이름의 생성AI인데, 텍스트를 입력하면 원하는 이미지를 만들어준다. 오픈AI는 회사 블로그를 통해 AI비디오 생성기 소라의 특징과 차이점, 향후 개발 방향을 상세히 소개했다. 주어진 명령(프롬프트)에 따라 비디오, 이미지 텍스트를 만들어내는 생성AI는 창작 세계를 강타하고 있다.

2023년을 강타한 할리우드 작가(WGA)와 배우 조합(SAG-AFTRA) 파업에서도 AI사용은 협상의 주요 쟁점이었다. 이미 많은 작가나 배우들이 창작 활동에 AI를 활용하고 있다. AI는 제작 현장에서 보조를 넘어 주체를 넘보고 있다. 소라 등 비디오 생성 AI는 창작의 시작(각본)에서 끝(영상)까지 책임질 수 있다. 이런 점에서 2024년 AI는 크리에이터 이코노미 지형을 바꿔놓을 가능성이 높다.

[정확한 디테일에 복잡한 장면 제작 가능]

소라는 메타(Meta)나 구글(Google), AI비디오 스타트업 런웨이(Runway), 피카 랩스(Pika Labs) 등이 공개한 AI비디오 생성툴과 유사한 형태다. 그러나 그동안의 기술 발전을 AI재현 수준에서 한단계 업그레이드된 모습이다.

기존 생성AI 기반 비디오 제너레이터의 경우 복잡한 장면을 정확히 시뮬레이션하는 데 어려움이 있었다. 특히, 원인과 결과를 이해하지 못하는 경우가 많았다.

예를 들어 어떤 사람이 쿠키를 한 입 베어물었다는 영상 제작을 주문하면 생성AI는 쿠키와 사람을 모두 만든다. 하지만 정작, 쿠키에 ‘물린 자국’이 없을 수도 있다.

또 왼쪽과 오른쪽을 혼동하는 등 프롬프트의 공간적 세부 사항을 혼동하는 경우가 많고 특정 카메라 궤적을 따라가는 등 시간 순으로 발생하는 이벤트에 대한 정확한 설명을 하지 못한다. 오픈AI는 소라 AI가 이런 비디오 생성 솔루션들의 약점을 상당히 보완했다고 밝혔다.

![[프리미엄 리포트] 미국 케이블TV 2025, 변화와 미래 전략](https://cdn.media.bluedot.so/bluedot.directmedialab/2025/05/vj931j_202505270106.png)